Uczenie maszynowe, lasery, ray tracing. Innowacyjne technologie odmienią wygląd gier i filmów

Branża telewizyjna nieśmiało wkracza w erę 8K, mimo iż jeszcze nie wszyscy nadawcy przekonali się do FullHD, o 4K nawet nie wspominając. Najnowsze karty graficzne wreszcie radzą sobie z rozdzielczością 4K, a przyszłe generacje konsol okiełznają ray tracing. Za kilka lat sprzęt będzie gotowy na nowy wymiar cyfrowej rozrywki. A jak twórcy poradzą sobie z tworzeniem immersyjnych treści w wysokich rozdzielczościach?

Odpowiednio wyszkolona sztuczna inteligencja będzie w stanie rozpoznać obiekty wyświetlane na ekranie i na podstawie wyuczonych wzorów podbić rozdzielczość poszczególnych elementów. Szkolenie SI to proces długotrwały, ale dający rewelacyjne efekty. Zanim przejdziemy do przykładów ze świata kina i filmu, spójrzmy na poniższy materiał:

Na tym filmie Nvidia zaprezentowała działanie generatywnej sieci kontradyktoryjnej (GAN) wyszkolonej do odtwarzania wyglądu ludzkich twarzy. Algorytmy przeanalizowały miliony zdjęć, aby nauczyć się, jak wygląda twarz człowieka. Dzięki tym danym jest w stanie przetworzyć rozpikselowany obraz w coś, co przypomina człowieka. Mogliśmy śmiać się z tego, że Agentach NCIS technicy wyciągają z kiepskich zdjęć ultraszczegółowe detale. Ale ta niedorzeczność okaże się znacznie mniej śmieszna, kiedy uświadomimy sobie, że do pewnego stopnia ich poczynania mogłyby być uzasadnione wykorzystaniem GAN.

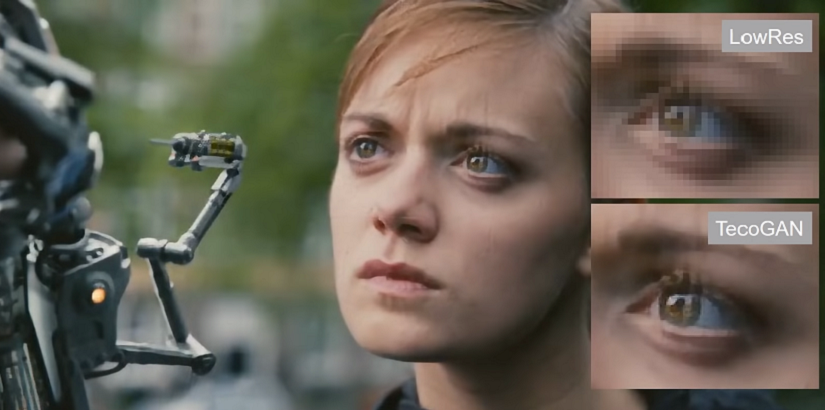

W powyższym filmie mamy pokazane działanie tej technologii sprowadzone do absurdu, gdyż naukowcy kazali sztucznej inteligencji stworzyć twarz z niemal przypadkowych pikseli. W przypadku filmów proces ten jest o wiele prostszy – najważniejsze elementy takie jak postaci czy architektura są na tyle duże, że algorytmy bez problemu je rozpoznają i będą w stanie poprawić ich jakość. Tu mamy dobry przykład działania tej technologii:

Warto w tym miejscu zauważyć, że SI nie musi wiedzieć, jak wygląda konkretny aktor czy budynek, aby przeskalować go do wyższej rozdzielczości. GAN wie, jak wygląda modelowy człowiek i na tej podstawie wyostrza obraz. A im dłużej sztuczna technologia będzie szkolona, tym lepsze rezultaty osiągnie. Spójrzmy na działanie jeszcze jednego algorytmu od Nvidii:

Tu widzimy, że zaawansowane SI są zdolne do tworzenia nawet dużych partii obrazu, jeśli jakiś fragment uległ degradacji bądź autor chce się go pozbyć. Zdolność do poprawiania oryginałów może przydać się w branży filmowej do poprawy klatkażu starszych produkcji i przeniesienia starych filmów nakręconych w 24 klatkach do 60 klatek. Sztuczna inteligencja przeanalizuje, jak powinien zmieniać się obraz w czasie i sama wygeneruje brakujące klatki. Tak, jak możemy zaobserwować to na tym filmie:

Warto zauważyć, że potencjał sztucznej inteligencji nie ogranicza się wyłącznie do dzieł filmowych, uczenie maszynowe może poprawić także wygląd gier. I nie mówię tu wyłącznie o skalowaniu obrazu do 4K, aby konsole obecnej generacji były w stanie pracować przy rozdzielczości UHD. Dzięki rozwiązaniom z zakresu sztucznej inteligencji nowego wyrazu mogą nabrać także gry retro, z których wyeliminujemy pikselozę.

Technologia uczenia maszynowego została wykorzystana m.in. do ulepszenia jednej z najdoskonalszych gier końca XX wieku, Final Fantasy VII. Oto jak ten tytuł wygląda z modem poprawiającym rozdzielczość dzięki zastosowaniu technologii sieci neuronowych:

Generatywne sieci kontradyktoryjne mogą odebrać robotę twórcom remake’ów robionych na kolanie, w których jedynym usprawnieniem jest podbicie szczegółowości tekstur i zwiększenie złożoności modeli 3D. Ale nie jest to technologia, na którą będziemy musieli czekać latami – nie bez powodu na wstępie wspomniałem o telewizorach Samsunga. Najnowsza generacja urządzeń z linii UHD wykorzystuje procesor sztucznej inteligencji do skalowania obrazu z wykorzystaniem technologii uczenia maszynowego. Algorytmy zastosowane przez koreańskiego producenta są jeszcze co prawda zbyt proste, aby w czasie rzeczywistym poprawiać jakość gier przy akceptowalnym opóźnieniu, ale poradzą sobie z przetwarzaniem filmów, w których wartość input laga nie jest istota.

Świetlista wisienka na torcie

Na sam koniec zostawmy temat ray tracingu, czyli przyszłościowej technologii, która sprawi, że wirtualne środowiska będą wyglądały bardziej wiarygodnie, gdyż w grach pojawią się realistyczne odbicia świetlne. Szerzej o tej technologii pisałem w tym artykule poświęconym kartom Nvidii z serii RTX, dlatego skupmy się na czymś istotniejszym – czyli jej zastosowaniu.

Jeszcze do niedawna Nvidia mogła pochwalić się, że jest jedyną firmą, która oferuje technologię śledzenia promieni świetlnych w grach, dziś tamte zapewnienia można odłożyć do lamusa. Ray tracing pojawił się nie tylko na starszych kartach firmy z serii GTX 10XX, które nie były projektowane z myślą o wykorzystaniu tego narzędzia, tak jak układy RTX. Trafił również do urządzeń od AMD.

Pod koniec marca firma Crytek zaprezentowała demo technologiczne zrealizowane przy wykorzystaniu karty Radeon RX Vega 56, które pokazuje, w jaki sposób można śledzić promienie świetlne na klasycznej karcie graficznej, bez wyspecjalizowanych rdzeni RT:

A to dopiero początek dobrych informacji dla miłośników kart od czerwonych. W tym tygodniu dowiedzieliśmy się, że następca PlayStation 4 będzie wyposażony w układy od AMD, które oddadzą w ręce graczy technologię ray tracingu. A ta znajdzie zastosowanie nie tylko w rękach grafików, ale i dźwiękowców, którzy wykorzystają ją do śledzenia przebiegu fali akustycznej w wirtualnym środowisku.

Pięknego powolne początki

Upowszechnienie się systemów sztucznej inteligencji może okazać się zbawieniem zarówno dla branży filmowej, jak i komputerowej. Z jednej strony powstają narzędzia, które ułatwiają przenoszenie fizycznych przedmiotów do wirtualnego środowiska, z drugiej zaś sieci neuronowe potrafią automatycznie poprawić wizualną jakość produkcji wyświetlanych na ekranie, zarówno filmów, jak i gier. Dodajmy do tego ray tracing w czasie rzeczywistym, który wkrótce może upowszechnić się w branży gamingowej, a zarysuje nam się piękny obraz przyszłości, w której korzystanie z telewizorów 4K – a w późniejszym terminie nawet 8K – w końcu będzie miało sens.

- 1

- 2 (current)

Źródło: Zdjęcie główne: YouTube, Nils Thuerey