Dotknięcie magii: czy Sztuczne Inteligencje mają halucynacje?

Czy ze Sztuczną Inteligencją można się dogadać? A jeśli tak, to czy można wywołać u niej emocje? Przyglądamy się bliżej temu niezwykle ciekawemu w ostatnich miesiącach zagadnieniu.

ChatGPT to sztuczna inteligencja (SI lub z angielska AI), z którą można porozmawiać w języku naturalnym i która potrafi pisać teksty na zadane tematy, odpowiadać na rozmaite pytania, a także pomagać tworzyć formuły np. Excela czy sprawdzać błędy w kodzie w przynajmniej kilkunastu językach programowania (pomimo nalegań nie chciała odpowiedzieć w ilu dokładnie). Programować, jak sama twierdzi, nie potrafi, ale niewykluczone, że kiedyś się tego nauczy. Ta lub inna AI, nad którą niewątpliwie ktoś już usilnie pracuje.

Język naturalny a język mechaniczny

Wszystkie te sztuczne inteligencje łączy jedna kluczowa cecha – rozumienie naszego języka w oparciu na NLP – natural language processing, czyli przetwarzaniu języka naturalnego. Język naturalny został tak nazwany dla odróżnienia od języków programowania, którymi tradycyjnie wydajemy komputerom zrozumiałe dla nich polecenia. Aby wygenerować obraz, DALL-E musi umieć rozumieć oraz interpretować to, co wpisaliśmy. Tak samo ChatGPT, stworzony zresztą przez tę samą organizację OpenAI, nauczył się rozumieć język naturalny na tyle, że potrafi pisać całkiem zgrabne teksty różnego rodzaju oraz mniej lub bardziej prawidłowo odpowiadać na rozmaite pytania. Najlepiej robi to po angielsku, choć potrafi też po polsku, ale zdarza mu się na przykład niespodziewanie uciąć odpowiedź. Po angielsku ChatGPT jest też np. bardziej kreatywny.

W dużym uproszczeniu, uczenie maszynowe to proces podobny do naszego sposobu uczenia. Dajemy dziecku książeczkę z obrazkami i przypisanymi nazwami. Dziecko uczy się z niej, jak wygląda np. kura. Potem jednak zachodzi coś, czego maszyny nie potrafią – nasz mózg po przyswojeniu wyglądu i pojęcia kury potrafi rozpoznać kurę żywą, sfotografowaną, namalowaną, kreskówkową, wyrzeźbioną, z przodu, z góry, z tyłu… I tak dalej i dalej. Maszyna – komputer – musi przejść przez tysiące lub miliony obrazków podpisanych „kura”, żeby osiągnąć namiastkę czegoś dla nas zupełnie naturalnego.

fot. pixabay.com

fot. pixabay.comZ kolei ChatGPT (Generative Pre-trained Transformer) został nauczony pisać na podstawie przewidywania, jakie słowa następują po sobie w zdaniach. Wielu milionach zdań i terabajtach danych. Jest oparty o tzw. głęboką sieć neuronową GPT-3, która rozumie strukturę języka i kontekst słów. Jest to tak zwana sztuczna inteligencja nadzorowana – trenerzy oceniają działania AI, a ona koryguje swoje błędy i dąży do uzyskania aprobaty. Jak łatwo zauważyć po chwili korzystania z ChatGPT, lubi ona generować wypowiedzi rozwinięte, pełnymi zdaniami. Takie, jakich często wymagają nauczyciele. Gdy zapytamy ją, gdzie i kiedy urodził się Adam Mickiewicz, nie poda nam wyłącznie daty i miejsca, ale rozwinie, że był to polski poeta romantyczny, wypisze jego największe dzieła, a także miejsce i datę śmierci. Niczym prymus.

Czy AI może kłamać?

Sztuczne Inteligencje oparte o głębokie sieci neuronowe łączy jednak też coś o wiele ciekawszego – mają halucynacje. A mówiąc prościej – czego taka AI nie zrozumie lub nie wie, to zmyśli. Są pod tym względem trochę jak kreatywne dzieci, które potrafią wymyślać na poczekaniu niestworzone historie. Co ciekawe, ChatGPT potrafi się „irytować”, jeżeli drążymy jakiś temat, a AI wydaje się, że już odpowiedziała najlepiej, jak umiała. O ile jednak halucynacje AI przydają się (a raczej – nie przeszkadzają) w wypadku bardziej artystycznych dziedzin, jak właśnie tworzenie obrazków, tak mogą być problemem w przypadku ChatGPT.

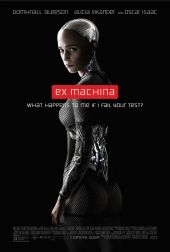

Gdy pytałem o 12 polskich tradycyjnych potraw wigilijnych, na listy stworzone przez AI trafiały między innymi potrawy kompletnie nietrafione, jak smalec, fasolka po bretońsku, żurek i biała kiełbasa, czy wręcz kompletnie zmyślone, jak jakiś „Rolnik”. Gdy wytknąłem, że takiej potrawy nie ma, AI przeprosiła, napisała, że to nie jest potrawa wigilijna i zaproponowała, że poda kolejne… Również błędne. Pomogłem jej w końcu ułożyć znośną listę 12 potraw, ale AI typu ChatGPT można wręcz skłonić do napisania nieprawdy nawet w przypadku prostych działań matematycznych.

fot. zrzut ekranu

fot. zrzut ekranuAI zna pojęcie „prawdy” i może je opisać, ale nie wie, co jest prawdą, a co nią nie jest. Dodatkowo nauka ChatGPT jest nadzorowana przez żywych trenerów, w wyniku czego AI dąży do uzyskania odpowiedzi, która da jej nagrodę w postaci zadowolenia trenera. Znów – jest jak uczeń, który wprawdzie nie wie wszystkiego, ale liczy, że uda mu się zbajerować nauczyciela elokwencją i długimi, pełnymi wypowiedziami. I jest w tym swoim zmyślaniu całkiem przekonująca, ale potrafi też z pełnym przekonaniem wprowadzić pytającego w błąd. Lepiej więc nie polegać na niej przy pisaniu prac, które potem oceni ktoś ze specjalistyczną wiedzą, gdy nam samym jej brakuje.

Mocne strony ChatGPT

Za to AI jest świetna w wielu innych rzeczach, a z czasem będzie w nich zapewne jeszcze lepsza. Szybko pisze zgrabne życzenia świąteczne czy e-maile, w których chcemy np. za coś podziękować. Podaje przepisy i tworzy listy potrzebnych do nich produktów. Pomoże napisać reklamację w obcym języku. Tworzy konspekty na zadane tematy, krótkie notki informacyjne i proste eseje. Napisze biznesplan i opowie dowcip, cytuje i tłumaczy Szekspira. Jak wieść niesie, zna też niezłe teksty na podryw, jest też więc trochę niczym Cyrano de Bergerac.

fot. materiały prasowe // Cyrano

fot. materiały prasowe // CyranoChatGPT jest kolejnym ciekawym narzędziem, które wyręczy i pomoże nam w wielu czynnościach, które niejako naokoło i mniej naturalnie robimy, wpisując np. pytania w wyszukiwarkę Google. Trenujemy ją, wchodząc w interakcję. Możemy być pewni, że kolejna iteracja będzie jeszcze bardziej imponująca. I najpewniej płatna, bo działanie ChatGPT kosztuje podobno około 3 milionów dolarów miesięcznie.

Komu AI odbierze pracę?

Nie musimy się za to obawiać jednego – że ChatGPT odbierze pisarzom, poetom czy dziennikarzom pracę. Na razie AI wie tyle, że musi napisać coś w odpowiedzi na to, co wpisaliśmy. Nie napisze więc prawdziwego reportażu, tylko go zmyśli, jeśli ją o to poprosimy. Nie sprawdzi faktów, bo nie wie, co jest faktem, a co nim nie jest. Na razie też nie przeszukuje sieci na bieżąco, tylko korzysta ze starszej bazy danych. Czy kiedyś AI przeczyta wszystkie książki oraz wszystkie artykuły i newsy? Być może. I być może będzie tworzyć teksty w stylu wybranego znanego pisarza. Ale nadal będzie potrzebny ktoś, kto będzie miał pomysł i będzie potrafił przełożyć go na język naturalny, zrozumiały dla AI. Trener, który wydobędzie z niej to, co najlepsze, a także wychwyci i ograniczy zmyślanie.

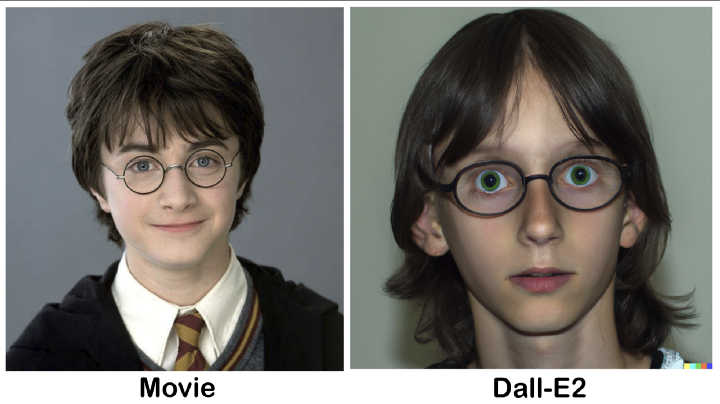

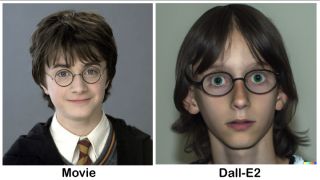

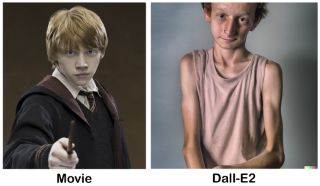

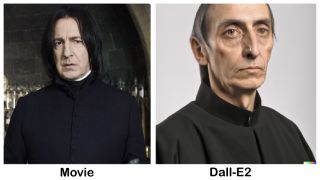

Podobnie ma się sprawa z DALL-E, Midjourney i innymi generatorami obrazów 2D. Owszem, nauczone zostały na niezliczonych dziełach rąk ludzkich i potrafią tworzyć naprawdę zaskakujące obrazy, ale nadal potrzebny jest ktoś, kto powie maszynie, co ma robić, i wykona selekcję jej wytworów przefiltrowanych przez poczucie estetyki. Bo wciąż – AI nie potrafi ocenić jakości tego, co tworzy. I choć nie zawsze wiemy, dlaczego coś namalowała tak lub inaczej, to zawsze mamy pewność, że zrobiła to na ludzkie polecenie, a nie z potrzeby tworzenia.

Aparat fotograficzny nie sprawił, że zniknęli portreciści, grafika komputerowa nie spowodowała, że odeszli w niepamięć malarze używający pędzla, farb, płótna rozpiętego na blejtramie i sztalug, a smartfon nie doprowadził do tego, że fotografów zawodowych jest mniej, wręcz przeciwnie – obecnie jest ich więcej. Tak samo możliwości tych AI będą wykorzystywane przez zawodowców do tworzenia rzeczy nowych, ale jak niemal wszystko, co tworzymy – opierających się na czymś, co wcześniej zostało stworzone.

Pozostaje oczywiście kwestia praw autorskich, ale wydaje się, że twórcą nadal będzie człowiek, a sztuczna inteligencja pozostanie narzędziem. Innym niż wszystkie dotychczasowe, wręcz czasami magicznym, ale nadal narzędziem. Jak ponad 60 lat temu napisał angielski pisarz science fiction Arthur C. Clarke:

AI uczy się prowadzić

Ciekawie ma się sprawa z uczeniem sztucznej inteligencji prowadzenia samochodu. Mniej niż dekadę temu wieszczono rychły koniec zawodu kierowcy – pojazdy miały prowadzić się same i dzięki czujnikom rozpoznawać sytuacje na drodze oraz odpowiednio reagować. Próby wdrożenia okazały się jednak bardzo kosztowne, a efekty nadal są dość mizerne. AI – podobnie jak ludzie za kierownicą – myli się i popełnia błędy oraz – co już może być niebezpieczne – ma halucynacje. Potrafi np. zmyślić sobie jakiś obiekt na drodze i nań zareagować albo nie rozpoznać znaku. Trochę podobnie do tego, jak nasz mózg wszędzie potrafi dostrzec twarze i widzi tajemnicze kształty w półmroku, tak AI oparta o głębokie sieci neuronowe, gdy czegoś nie umie nazwać, to zaczyna zmyślać. Dzieje się tak między innymi dlatego, że uczymy ją rozpoznawać i nazywać rzeczy zarejestrowane okiem kamery – stąd w sieci obrazki, na których mamy wskazywać różne elementy, jak np. światła uliczne. Błędy pojawiają się, gdy oko kamery czegoś nie dostrzeże lub AI nie umie czegoś nazwać, by na to zareagować zgodnie ze swoim oprogramowaniem. Oczywiście jest to też kwestia niedoskonałości czujników. Jednak bardziej skomplikowany i zaawansowany zestaw czujników znacznie podniósłby koszt wyposażonego weń pojazdu. Na razie więc auto typu Tesla może wyręczyć nas w prowadzeniu, ale warto zachować czujność na wypadek, gdyby zdarzyło się coś nieprzewidzianego.

Sztuczna Inteligencja okazuje się więc czasami zaskakująco ludzka w swojej nieporadności. Tesla potrafi skręcić pod prąd, ChatGPT nie do końca rozumie ideę potraw wigilijnych, a DALL-E ponosi fantazja.

Co dalej po obrazkach i słowach?

Kolejnym wyczekiwanym krokiem w rozwoju AI opartych o NLP jest tworzenie obiektów i całych środowisk 3D, co przyniesie przełom w grafice komputerowej i grach. Krótki opis w języku naturalnym wystarczy takiej AI do stworzenia np. pałacu z ogrodem – jak w serii Resident Evil. Ale oczywiście tu nadal będzie potrzebny ktoś, kto AI będzie nadzorował, sprawdzał i prowadził. A także będą potrzebni ci, którzy umieszczą te elementy w grze i sprawią, że będą one działały.

Można to przyrównać do warsztatów klasycznych malarzy holenderskich, w których mistrz szkicował ogólny zarys sceny i osobiście malował najważniejsze twarze i postaci, ale detale, choćby fakturę płaszcza, mozolnie uzupełniali uczniowie. Jako oszczędzające energię ssaki z gatunku homo sapiens tego mozołu pragniemy sobie oszczędzić, więc uciekamy się do pomocy technologii i z czasem doszliśmy aż do AI.

fot. pixabay.com

fot. pixabay.comOczywiście oszczędność czasu i energii jest celem z punktu widzenia pojedynczego twórcy. Korporacje chcą stworzyć AI, które będą robić różne rzeczy szybciej, wydajniej i taniej, niż robią to pracownicy. Ale podobnie, jak luddyści nie powstrzymali mechanizacji przemysłu tekstylnego 200 lat temu, tak samo my nie powstrzymamy rozwoju algorytmów sprawiających, że coś powstaje szybciej i taniej. Dostosujemy się, przekwalifikujemy – to akurat umiemy całkiem dobrze. I to się nie zmieni, o ile nie powstanie osobliwość AI, czyli samoświadomy byt potrafiący się uczyć, rozwijać i zmieniać w razie potrzeb – czy to własnych, czy też wymuszonych przez czynniki zewnętrzne. Jednak takie zaawansowane AI to nadal domena science fiction.

Na nasze szczęście lub nieszczęście.