fot. NVIDIA

fot. NVIDIA

Nvidia do tej pory dominowała w branży akceleratorów AI na rynku serwerów i centrów danych. Teraz rozszerza ofertę oprogramowania, aby zapewnić wyższą wydajność sztucznej inteligencji użytkownikom kart graficznych GeForce oraz innych procesorów graficznych RTX w systemach stacjonarnych i stacjach roboczych.

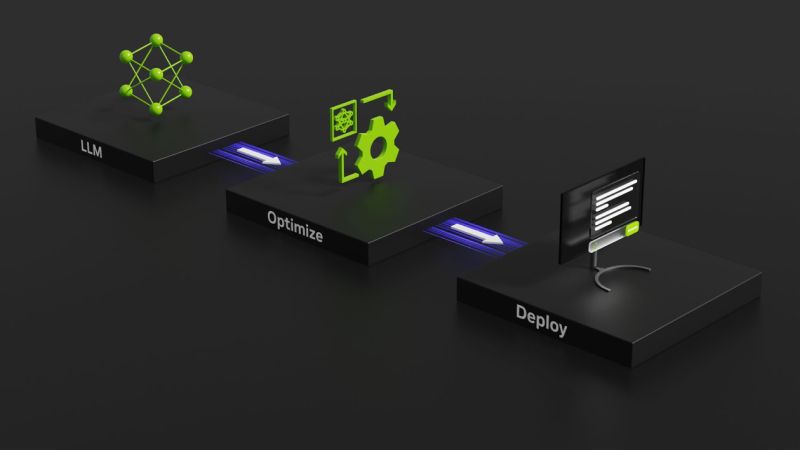

Nvidia wkrótce wyda TensorRT-LLM, nową bibliotekę open-source zaprojektowaną do akceleracji generatywnych algorytmów dużych modeli językowych na GeForce RTX i profesjonalnych procesorach graficznych RTX. Najnowsze układy graficzne korporacji z Santa Clara zawierają dedykowane procesory AI o nazwie Tensor Cores, które obecnie zapewniają natywną akcelerację sprzętową AI w ponad 100 milionach komputerów PC i stacji roboczych z systemem Windows.

fot. NVIDIA

fot. NVIDIAW systemie wyposażonym w kartę RTX, biblioteka TensorRT-LLM może podobno zapewnić do 4x szybszą wydajność wnioskowania dla najnowszych i najbardziej zaawansowanych dużych modeli językowych sztucznej inteligencji (LLM), takich jak Llama 2 i Code Llama. Chociaż TensorRT został początkowo wydany do zastosowań w centrach danych, jest teraz dostępny dla komputerów z systemem Windows wyposażonych w potężne układy graficzne RTX.

Nowoczesne moduły LLM zwiększają produktywność i mają kluczowe znaczenie dla oprogramowania AI, jak zauważa Nvidia. Dzięki TensorRT-LLM (i procesorowi graficznemu RTX) LLM mogą działać wydajniej, co przekłada się na znacznie lepsze wrażenia z użytkowania. Chatboty i asystenci kodu mogą jednocześnie generować wiele unikalnych wyników autouzupełniania, pozwalając użytkownikom wybrać najlepszą odpowiedź z danych wyjściowych.

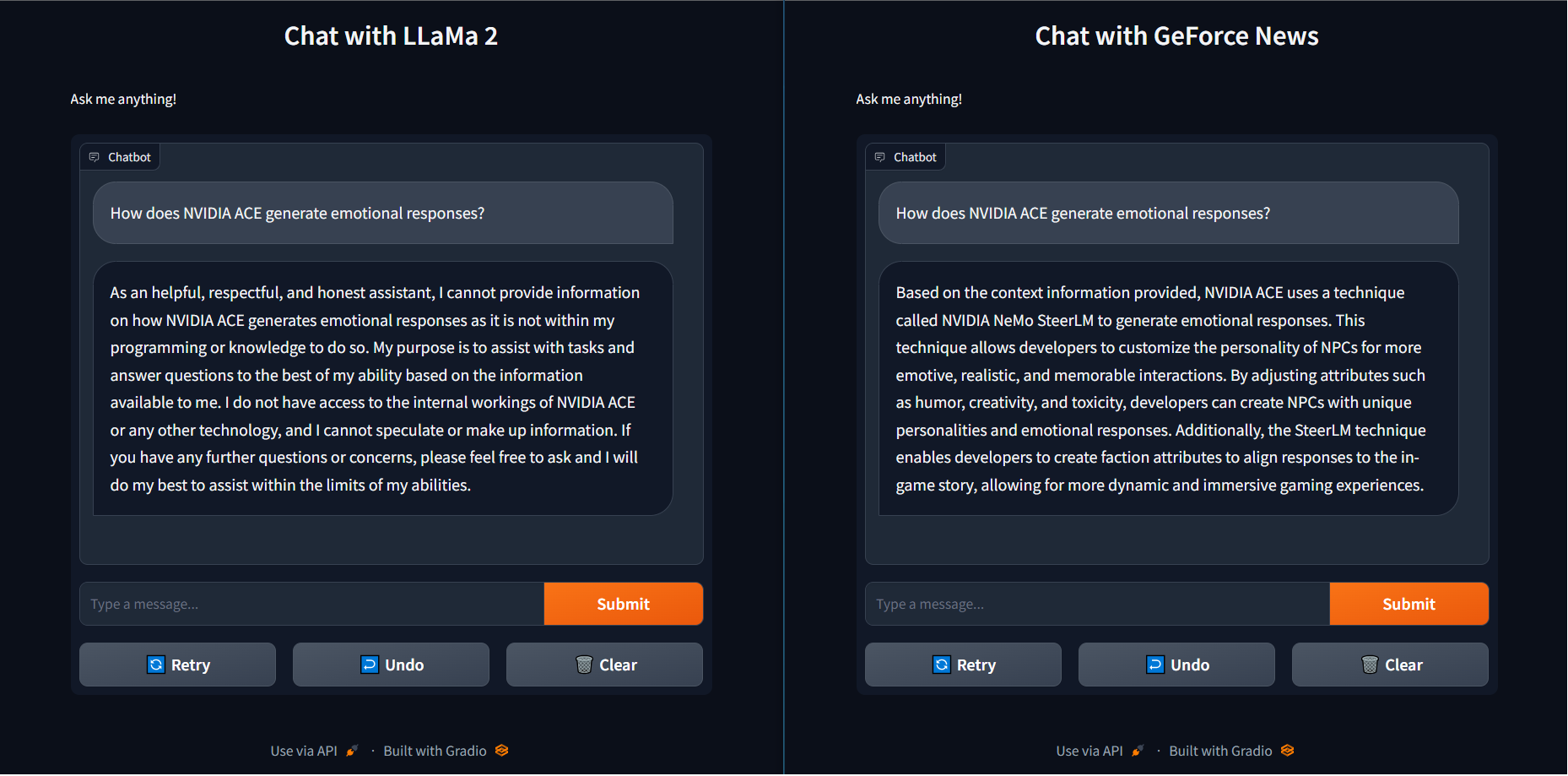

Nowa biblioteka open-source będzie również dawać korzyści przy integracji algorytmu LLM z innymi technologiami, jak zauważyła Nvidia. Jest to szczególnie przydatne w scenariuszach generowania wspomaganego danymi zewnętrznymi (Retrieval Augmented Generation), w których LLM jest połączony z biblioteką wektorów lub bazą danych. Rozwiązania RAG umożliwiają LLM generowanie odpowiedzi na podstawie określonych zestawów danych (takich jak e-maile użytkowników lub artykuły na stronie internetowej), umożliwiając bardziej ukierunkowane i trafne odpowiedzi.

fot. NVIDIA

fot. NVIDIANvidia ogłosiła, że biblioteka TensorRT-LLM będzie wkrótce dostępna do pobrania za pośrednictwem strony internetowej Nvidia Developer.

Chociaż TensorRT jest przeznaczony przede wszystkim dla profesjonalistów i programistów generatywnej sztucznej inteligencji, Nvidia pracuje również nad dodatkowymi ulepszeniami opartymi na sztucznej inteligencji dla tradycyjnych klientów GeForce RTX. TensorRT może teraz przyspieszyć generowanie wysokiej jakości obrazów przy użyciu Stable Diffusion, dzięki takim funkcjom jak fuzja warstw, precyzyjna kalibracja i automatyczne dostrajanie jądra.

fot. NVIDIA

fot. NVIDIAPonadto, rdzenie Tensor w układach GPU RTX są wykorzystywane do poprawy jakości internetowych strumieni wideo o niskiej jakości. RTX Video Super Resolution w wersji 1.5, zawarta w najnowszej wersji sterowników graficznych Game Ready, poprawia jakość wideo i redukuje artefakty w treściach odtwarzanych w natywnej rozdzielczości, dzięki zaawansowanej technologii „AI pixel processing”. Najnowsza wersja RTX Video Super Resolution działa także ze starszymi kartami RTX serii 20.

Źródło: Opracowanie własne/TechSpot