Uczeń liceum otoczony przez policjantów i skuty kajdankami po tym, jak sztuczna inteligencja pomyliła paczkę doritosów z… Pistoletem!

W sztuczną inteligencję inwestuje się miliardy dolarów, a jej zastosowanie staje się coraz bardziej powszechne, jednak wciąż obserwujemy niepokojące przypadki błędnego działania tej dalece niedoskonałej technologii.

fot. materiały prasowe

fot. materiały prasowe

Doskonały przykład miał miejsce w jednym z liceów w Baltimore, gdzie uczeń został otoczony przez policję po tym, jak sztuczna inteligencja pomyliła z bronią najzwyklejszą paczkę chipsów Doritos. Takiego Allena, 16-letni ucznia liceum Kenwood High School w hrabstwie Baltimore w stanie Maryland, spotkała nieprzyjemna niespodzianka, gdy w zeszłym tygodniu siedział z przyjaciółmi po treningu futbolowym i czekał na transport do domu. Około 20 minut po tym, jak skończył jeść paczkę chipsów Doritos, przed szkołą pojawiło się niemal dziesięć radiowozów policyjnych. Funkcjonariusze wysiedli z samochodów i, celując bronią w Allena, kazali mu położyć ręce na głowie i podejść do nich. Uczeń powiedział, że następnie kazano mu uklęknąć i założono mu kajdanki. Policja hrabstwa Baltimore potwierdziła później, że Allen został skuty kajdankami, ale nie aresztowany.

Na nieszczęście dla Takiego Allena sztuczna inteligencja, która na żywo analizuje nagrania z kamer monitoringu szkolnego, pomyliła pogniecioną paczkę chipsów Doritos z bronią palną i powiadomiła policję.

„Czy masz przy sobie broń?” – zapytał jeden z funkcjonariuszy chłopca, podczas gdy inni przeszukiwali jego przyjaciół.

Po przejrzeniu nagrań, na których sztuczna inteligencja zidentyfikowała broń, policja zajrzała do pobliskiego kosza na śmieci i znalazła torebkę chipsów.

„Myślę, że sposób, w jaki jadłeś chipsy... Doritos, czy jak tam się nazywają... sprawił, że system uznał je za broń” – powiedział jeden z funkcjonariuszy. Pamiętaj więc: w obecności AI nigdy nie jedz chipsów w niewłaściwy sposób!

Inny policjant dodał, że „sztuczna inteligencja nie jest najlepsza”, co jest sporym niedopowiedzeniem.

Kurator oświaty dr Myriam Rogers powiedziała dziennikarzom, że system działał zgodnie z przeznaczeniem. „Program opiera się na weryfikacji przez człowieka i w tym przypadku program zrobił to, co miał zrobić, czyli zasygnalizował alarm, aby ludzie mogli sprawdzić, czy w tej chwili istnieje powód do niepokoju” – powiedziała Rogers.

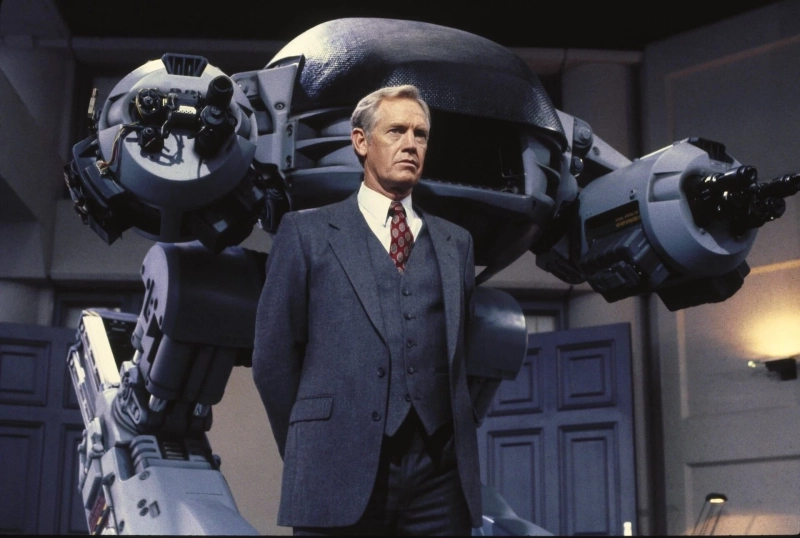

Obrona – że system „zrobił to, co miał zrobić” – przyprawia o dreszcze, przywodząc na myśl dystopijne science fiction. Można przypomnieć sobie scenę z filmu RoboCop, w której robot egzekwujący prawo ED-209 „wariuje” i brutalnie rozstrzeliwuje jednego z pracowników podczas prezentacji. Ten system również „działał zgodnie z przeznaczeniem” – błędnie zidentyfikował zagrożenie i przystąpił do jego „neutralizacji”. „Jestem pewien, że to tylko usterka...” powiedział w filmie dyrektor odpowiedzialny za robota ED-209.

Co zrozumiałe, Taki Allen nie podziela punktu widzenia Rogersa. „Żadna paczka chipsów nie powinna być pomylona z bronią”.

Dyrektor szkoły Kate Smith wysłała do rodziców list po tym incydencie, podkreślając znaczenie bezpieczeństwa uczniów, ale Allen powiedział, że Smith porozmawiała z nim dopiero trzy dni po tym zdarzeniu.

Błąd ten spowodował, że lokalni politycy zażądali przeglądu stosowania przez szkołę nadzoru opartego na sztucznej inteligencji.

Allen powiedział, że teraz czeka w środku budynku szkolnego po treningu futbolowym, ponieważ nie uważa, że „wychodzenie na zewnątrz jest wystarczająco bezpieczne, a zwłaszcza jedzenie chipsów lub picie czegoś”.

Omnilert, twórca systemu sztucznej inteligencji używanego przez szkołę, powiedział BBC News: „Żałujemy, że doszło do tego incydentu...”, ale dodał: „Chociaż później ustalono, że przedmiot nie był bronią palną, proces zadziałał zgodnie z zamierzeniami: priorytetowo potraktowano bezpieczeństwo i świadomość poprzez szybką weryfikację przez człowieka”. Znajduję więc wyjątkowo ironicznym zbiegiem okoliczności fakt, że korporacja, która stworzyła robota ED-209 w RoboCop, nazywała się OmniCorp.

Tym bardziej niepokoić nas powinny próby stosowania sztucznej inteligencji w autonomicznych robotach dla wojska, policji czy innych służb. Wystarczy, że policja w Stanach ma czułe spusty i nerwowe palce, nie potrzeba nam jeszcze morderczych robotów widzących broń w przedmiotach codziennego użytku niczym myśliwi mylący wszystko i wszystkich z dzikami.

Źródło: Opracowanie własne/TechSpot

naEKRANIE Poleca

ReklamaKalendarz premier seriali

Zobacz wszystkie premieryDzisiaj urodziny obchodzą

ur. 1960, kończy 65 lat

ur. 1975, kończy 50 lat

ur. 1968, kończy 57 lat

ur. 1985, kończy 40 lat

ur. 1983, kończy 42 lat