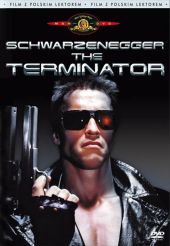

Apokalipsa rodem z Terminatora nadal możliwa? James Cameron wskazał też dwa inne zagrożenia

Od dziesiątek lat przewiduje się w kinie, że sztuczna inteligencja może być wielkim zagrożeniem dla istnienia ludzkości. James Cameron podtrzymuje to przekonanie po latach, ale wskazuje też na dwa inne zagrożenia.

Źródło: materiały prasowe

Źródło: materiały prasowe

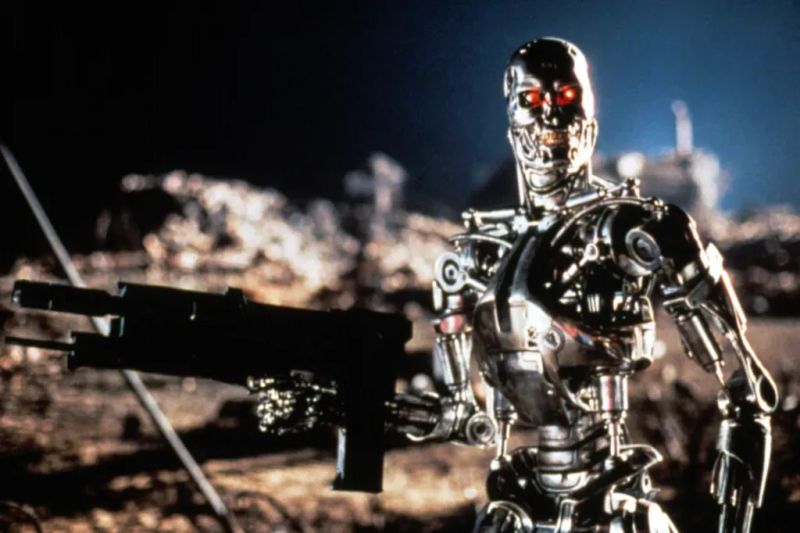

Rozwój sztucznej inteligencji budzi coraz większe obawy wśród społeczeństwa, szczególnie jeśli chodzi o używanie AI w dziedzinach sztuki. James Cameron, twórca Terminatora, ponownie podkreślił, że dalszy rozwój tej technologii może doprowadzić do apokalipsy, którą przedstawił w filmach z tej serii. Jakie są inne dwa zagrożenia, które jego zdaniem mogą zagrozić istnieniu ludzkości?

Co dalej z Obcy kontra Predator? Twórca nowego serialu porównał sytuację do MCU

James Cameron porozmawiał o tym z Rolling Stone:

Uważam, że nadal istnieje zagrożenie apokalipsy rodem z Terminatora, jeśli uzbroimy sztuczną inteligencję do poziomu arsenału nuklearnego. Przez to, jak szybko są podejmowane działania w teatrze zbrojnym, konieczne będzie aby to superinteligencja się tym zajmowała. Może będziemy mądrzy i zachowamy czynnik ludzki w tym procesie. Ludzie też nie są idealni. W przeszłości było wiele międzynarodowych pomyłek, które zepchnęły nas na skraj wojny nuklearnej.

Istnieją trzy rodzaje zagrożenia dla ludzkości: zmiany klimatyczne i degradacja świata naturalnego, bronie nuklearne i superinteligencja. Wszystkie pojawiają się w podobnym momencie. Może superinteligencja jest odpowiedzią na to. Nie wiem. Nie przewiduje tego, ale może tak właśnie jest.

Przeboje lat 90. - ranking największych filmów

Źródło: gamesradar.com

naEKRANIE Poleca

ReklamaKalendarz premier seriali

Zobacz wszystkie premieryDzisiaj urodziny obchodzą

ur. 1977, kończy 48 lat

ur. 1978, kończy 47 lat

ur. 1976, kończy 49 lat

ur. 1992, kończy 33 lat

ur. 1964, kończy 61 lat

Lekkie TOP 10