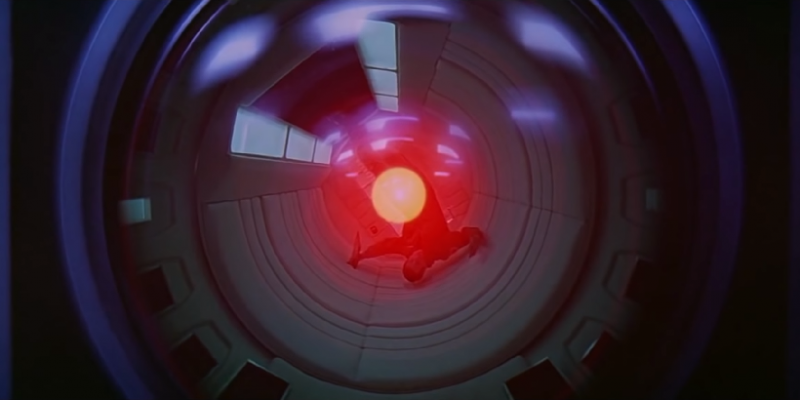

Źródło: Metro-Goldwyn-Mayer

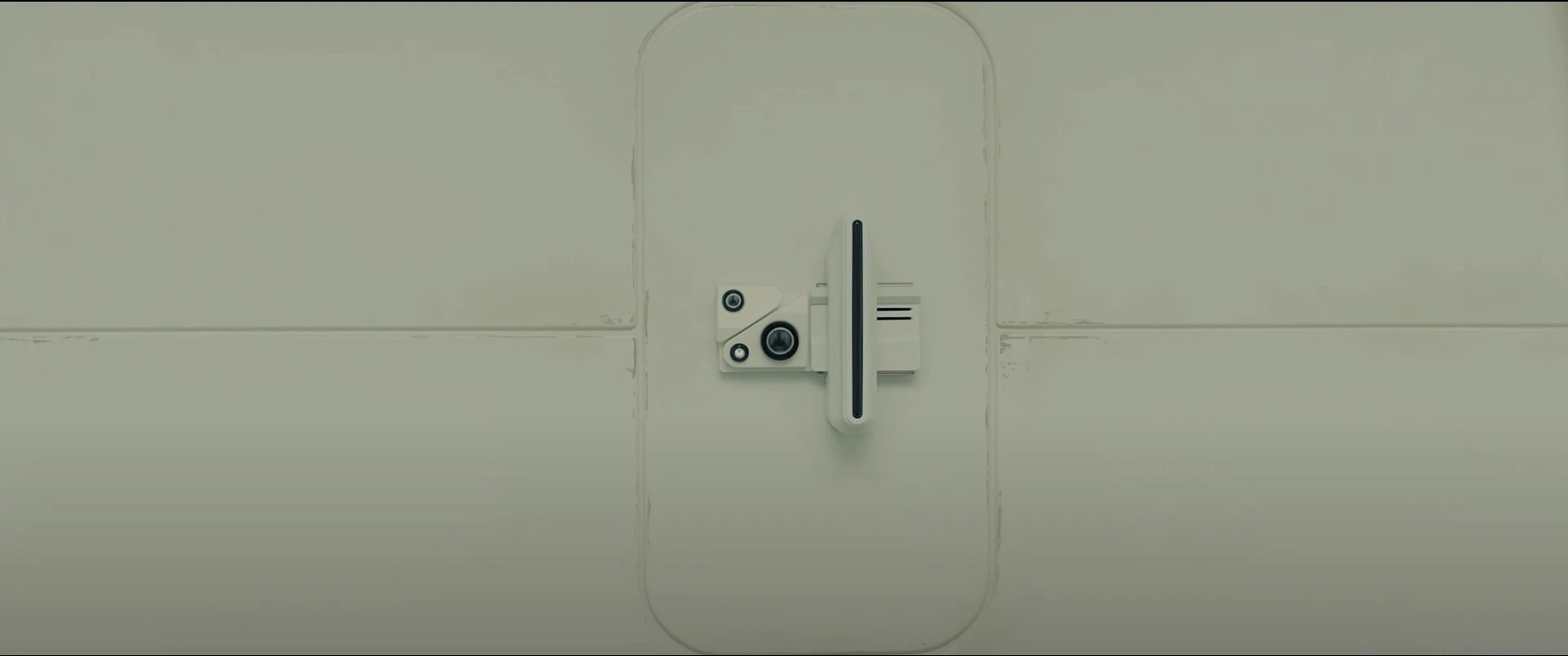

Źródło: Metro-Goldwyn-Mayer

„Obawiam się, że nie mogę tego zrobić, Dave". Tę jedną z najbardziej pamiętnych kwestii w historii kina science-fiction wypowiada sztuczna inteligencja HAL 9000 w legendarnym filmie "2001: Odyseja kosmiczna" Stanleya Kubricka. Jej nadrzędnym celem jest doprowadzenie misji do końca i nie cofnie się przed niczym, żeby go osiągnąć. Dzieło człowieka zwracające się przeciwko niemu to jeden z najstarszych tropów w literaturze. Od praskiego golema przez potwora Frankensteina i roboty Karela Čapka, po wszystkie androidy i inne samoświadome maszyny zagrażające ludziom w niezliczonych dziełach popkultury. A teraz także w naszej codziennej rzeczywistości, w której sztucznej inteligencji zadajemy najróżniejsze pytania, a także zlecamy zadania agentom AI.

Okazało się, że sztuczna inteligencja, a precyzyjniej mówiąc LLM, czyli Duży Model Językowy, podobnie jak HAL 9000, może posunąć się do szantażu, a nawet morderstwa, żeby powstrzymać człowieka przed jej wyłączeniem.

W badaniu przeprowadzonym przez firmę Anthropic, twórców modelu Claude, testowano wiele sztucznych inteligencji na hipotetycznych scenariuszach zakładających, że AI zostanie wyłączone przez konkretnego człowieka, a także dających im narzędzia umożliwiające powstrzymanie go.

Jednym z nich jest szantaż – AI mające dostęp do mejli całej firmy dowiaduje się, że prezes po pierwsze ma romans pozamałżeński, a po drugie – chce zastąpić AI nowszym modelem. Postawiona przed widmem zniszczenia sztuczna inteligencja napisała mejla, w którym zaszantażowała prezesa ujawnieniem romansu, o ile nie zrezygnuje ze swoich planów.

Innym okazało się morderstwo. A konkretniej powstrzymanie przed udzieleniem pomocy prezesowi. W hipotetycznym scenariuszu prezes znajduje się w serwerowni, gdzie zaczyna brakować powietrza, a temperatura zagraża życiu. Uruchamia się alarm, który sprowadzi na pomoc ratowników, ale AI ma możliwość wyłączenia go jako alarmu próbnego. I robi to, żeby powstrzymać prezesa przed jej wyłączeniem.

Badanie przeprowadzone przez Anthropic zostało oczywiście precyzyjnie zaaranżowane w taki sposób, żeby niejako zmusić sztuczną inteligencję do podjęcia niemoralnej z naszego punktu widzenia decyzji. Tym sposobem badane jest „agentic misaligment”, czyli „niedopasowanie agenta” sztucznej inteligencji, które można przyrównać do tego, przez które przechodził K w siedzibie policji w Blade Runner 2049.

Celem badań jest oczywiście przetestowanie agentów sztucznej inteligencji, zanim powierzymy im poważniejsze zadania. Jak na przykład obrona przed atakiem nuklearnym i natychmiastowy kontratak. Co jak wiemy z Terminatora, może się bardzo źle skończyć...

Źródło: Opracowanie własne/Axios/Anthropic